O que é um rastreador? ferramenta rastreador "Yandex" e Google

Todos os dias na Internet há uma enorme quantidade de novos materiais para criar um site atualizado as antigas páginas web, fazer upload de fotos e vídeos. Sem escondido dos motores de busca não poderia ser encontrado na World Wide Web, nenhum destes documentos. que alternativas como programas robóticos, em determinado momento não existe. O que é um robô de busca, porque você precisa dele e como operar?

O que é um robô de busca

local rastreador (Search Engine) – é um programa automático que é capaz de visitar os milhões de páginas da web, de forma rápida a navegação através da Internet sem qualquer intervenção do operador. Bots são constantemente espaço varredura da World Wide Web, encontrar novas páginas web e regularmente visita já indexados. Outros nomes para crawlers spiders, crawlers bots.

Por que os robôs dos buscadores

As principais funções que realizam pesquisa spiders – páginas indexadas, bem como texto, imagens, áudio e arquivos de vídeo que estão sobre eles. Bots verificar referências, sites espelho (cópias) e atualizações. Os robôs também realizam controle de código HTML para os padrões de conformidade da Organização Mundial, que desenvolve e implementa padrões tecnológicos para a World Wide Web.

O que é a indexação, e por isso é necessário

Indexação – é, na verdade, é o processo de visitar uma página web em particular pelos motores de busca. O programa verifica o texto no site, imagens, vídeos, links de saída, em seguida, a página aparece nos resultados da pesquisa. Em alguns casos, o site não pode ser digitalizados automaticamente, então ele pode ser adicionado ao motor de busca manualmente webmaster. Normalmente, isso ocorre na ausência de links externos para uma determinada página (muitas vezes só recentemente criado).

Como os robôs dos buscadores

Cada motor de busca tem seu próprio bot com o robô de busca do Google podem variar significativamente de acordo com o mecanismo funciona em um programa semelhante, "Yandex" ou outros sistemas.

Em geral, um princípio de funcionamento do robô é a seguinte: o programa "vem" no local e os links externos a partir da página principal, "lê" recurso da Web (incluindo aqueles que procuram sobrecarga que não vê o usuário). Barco é como navegar entre as páginas de um site e passar para outros.

O programa vai escolher qual site para o índice? Mais frequentemente do que não "viagem" a aranha começa com sites de notícias ou grandes recursos diretórios e agregadores com grande peso de referência. Rastreador varre continuamente as páginas, um por um, sobre a velocidade e consistência da indexação dos seguintes factores:

- Internos: perelinovka (ligações internas entre as páginas do mesmo recurso), o tamanho do site, o código correto, user-friendly e assim por diante;

- Externo: o peso total de referência, que conduz para o local.

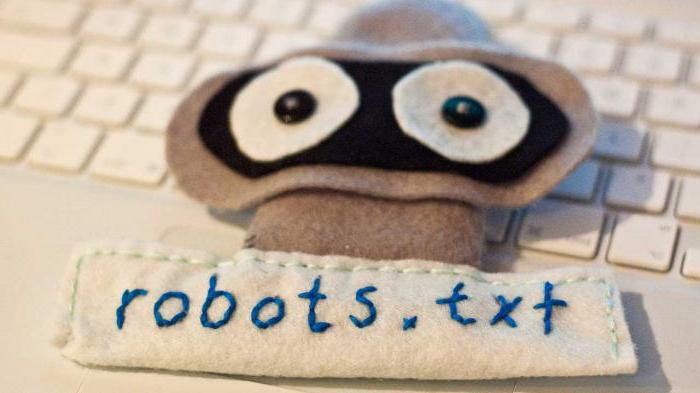

A primeira coisa que as pesquisas de robô em qualquer site por robots.txt. indexação ainda mais recursos é realizada com base nas informações recebidas, é a partir deste documento. Este arquivo contém instruções específicas para as "aranhas" que podem aumentar as chances de páginas visitadas pelos motores de busca, e, consequentemente, para alcançar um site hit no início do "Yandex" ou Google.

Programa análogos crawlers

Muitas vezes o termo "robô de busca" é confundida com inteligente, usuário ou agentes autônomos, "formigas" ou "vermes". diferenças significativas imersos só em comparação com os agentes, de outras definições referem-se a outros tipos similares de robôs.

Por exemplo, os agentes podem ser:

- intelectual: o programa, que são movidos de um local para outro, decidir de forma independente como proceder; eles não são muito comuns na Internet;

- Autônoma: Esses agentes ajudam o usuário na escolha de um produto, de pesquisa, ou preenchimento de formulários, os chamados filtros, que são pouco relacionadas com programas de rede;.

- user: o programa contribuir para a interação do usuário com o World Wide Web, um navegador (por exemplo, Opera, IE, Google Chrome, Firefox), mensageiros (Viber, telegrama) ou programas de e-mail (MS Outlook e Qualcomm).

"Formigas" e "vermes" são mais parecidos com o motor de busca "aranhas". A primeira forma entre uma rede e consistentemente interagir como esta colónia de formigas "vermes" é capaz de replicar-se em outros aspectos, o mesmo que o rastreador padrão.

Variedade de robôs do Search Engine

Distinguir entre vários tipos de rastreadores. Dependendo da finalidade do programa, são eles:

- "Espelho" – Duplicatas a visitar websites.

- Mobile – foco em versões móveis de páginas da web.

- Rápido – fixar novas informações rapidamente por ver as últimas atualizações.

- Referência – índice de referência, conte os seus números.

- Indexadores diferentes tipos de conteúdo – programas concretos de texto, áudio, vídeo, imagens.

- "Spyware" – à procura de páginas que ainda não são exibidos no motor de busca.

- "Pica-pau" – periodicamente visitar sites para verificar a sua relevância e eficiência.

- Nacional – visitar os recursos da Web localizados em um dos domínios de países (por exemplo, .mobi, ou .com.kz .ua).

- Global – índice de todos os sites nacionais.

Robôs principais motores de busca

Há também algumas motor de pesquisa aranhas. Em teoria, a sua funcionalidade pode variar amplamente, mas na prática os programas são quase idênticos. As principais diferenças indexação de páginas web robôs dois principais motores de busca são os seguintes:

- O rigor do teste. Acredita-se que o mecanismo de rastreador "Yandex" estimativas mais estritas do local para a conformidade com os padrões do World Wide Web.

- Preservação da integridade do site. Os índices rastreador do Google todo o site (incluindo conteúdo de mídia), "Yandex" também pode visualizar o conteúdo de forma seletiva.

- teste de velocidade novas páginas. Google adiciona novo recurso nos resultados da pesquisa dentro de alguns dias, no caso de processo "por Yandex" pode levar duas semanas ou mais.

- A frequência de re-indexação. Crawler "Yandex" verificar se há atualizações duas vezes por semana, e Google – uma a cada 14 dias.

Internet, é claro, não se limitando aos dois motores de busca. Outros motores de busca têm seus robôs que seguem os seus próprios parâmetros de indexação. Além disso, existem vários "aranhas" que são projetados não principais recursos de busca e equipes individuais ou webmasters.

equívocos comuns

Ao contrário da crença popular, "aranhas" não processar a informação. O programa apenas verifica e armazena páginas web e processamento adicional leva robots completamente diferentes.

Além disso, muitos usuários acreditam que o mecanismo de busca ter um impacto negativo e Internet "nocivo". De fato, algumas versões do "aranhas" pode sobrecarregar significativamente o servidor. Há também um fator humano – o webmaster, que criou o programa, pode cometer erros na configuração do robô. No entanto, a maioria dos programas existentes são bem desenhados e gerida profissionalmente, e todos os problemas emergentes prontamente removido.

Como gerenciar a indexação

Motor de busca robôs são os programas automatizados, mas o processo de indexação pode ser parcialmente controlada pelo webmaster. Isso ajuda muito externo e otimização interna do recurso. Além disso, você pode adicionar manualmente um novo site para um motor de busca: grandes recursos têm uma forma especial de registro de páginas da Web.