Apresentação de informações em um computador: usar os exemplos

Se uma pessoa está envolvida no estudo da tecnologia de computador não é superficial, mas a sério, certamente deve estar ciente de que são as diferentes formas de informação no computador. Esta questão é um princípio essencial, porque não só o uso de software e sistemas operacionais, mas também a programação é, em princípio, com base nestes Acaz.

Lição "Apresentação de informações no computador": o básico

Geralmente, equipamentos de informática para a maneira como ela percebe a informação ou comandos, converte-los para os formatos de arquivo e fornece ao usuário o resultado final é um pouco diferente dos conceitos convencionais.

O fato de que todos os sistemas existentes com base em apenas dois operadores lógicos – "verdadeiro" e "falso» (verdadeiro, falso). Em um sentido mais simples é "sim" ou "não".

Entende-se que a ciência palavras computador não entender por que um sistema digital especial com código condicional foi criado no alvorecer da tecnologia informática, em que a homologação da unidade relevante, e negação – zero. Isso é exatamente o que apareceu a chamada representação binária de informações em um computador. Dependendo da combinação de uns e zeros é determinado e o tamanho do objecto de dados.

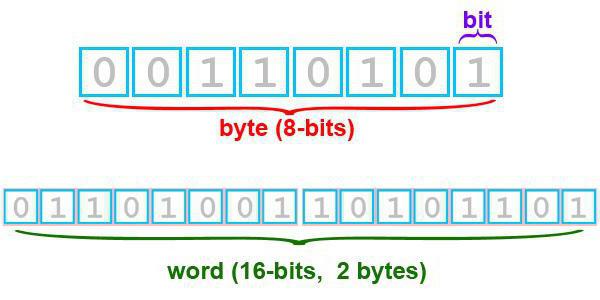

A menor unidade deste tipo é o tamanho um pouco – bit, que pode ter um valor de 0 ou 1. Contudo, os sistemas modernos com quantidades tão pequenas não estão funcionando, e quase todas as formas de apresentar as informações no computador são reduzidos a usar apenas oito bits, o que em conjunto constituem bytes (dois para a oitava potência). Assim, em um único byte pode ser feita de qualquer codificação dos caracteres de 256 possíveis. E é um código binário é o alicerce de qualquer do objeto informações. Deve ser entendido, como parece na prática.

Informática: a prestação de informações no computador. número de ponto fixo

Desde que foi originalmente falando de números, nós consideramos como o sistema trata-los. Representação da informação numérica no computador hoje pode ser dividido em processar números com ponto fixo e flutuante. O primeiro tipo também pode ser atribuído inteiros comuns, que depois do ponto decimal vale zero.

Acredita-se que os números deste tipo pode ter 1, 2, ou 4 bytes. O chamado byte cabeça é responsável pela sinal do número, enquanto um sinal positivo corresponde a zero, e negativo – unidade. Assim, por exemplo, uma representação de 2 bytes do intervalo de valores para os números de positivos na gama de 0 a 16 01 de fevereiro, que é 65535, e para os números negativos – -2 15 a 2 15 -1, o que é igual a um intervalo de números de -32768 a 32767.

representação de ponto flutuante

Agora, considere o segundo tipo de números. O fato de que as lições do currículo escolar em "Relato de um computador" (grau 9) números de ponto flutuante não são considerados. Operações com eles são bastante complexas e são usados, por exemplo, em jogos de computador. By the way, um pouco distraído do assunto, deve ser dito que, para placas de vídeo modernas um dos principais indicadores de desempenho é a velocidade das transações é com esses números.

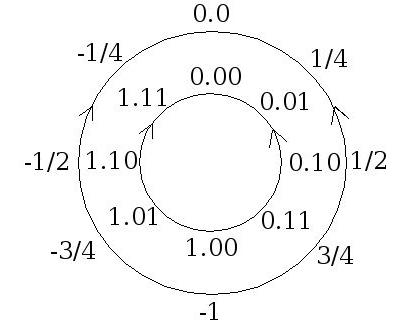

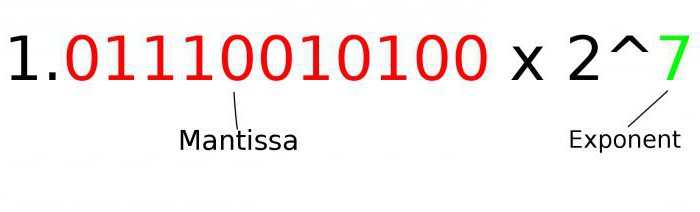

Aqui usamos a forma exponencial, em que a posição do ponto decimal pode ser alterado. Como a fórmula básica, que mostra uma representação de um número qualquer de aceito Um seguinte: A = m A * q-P , em que m A – é a mantissa, q P – é uma raiz, e P – número de ordem.

A mantissa deve satisfazer o requisito de q -1 ≤ | m A | <1, então deve ser fracção binária adequada contendo o dígito após o ponto decimal, que é diferente de zero, e a ordem de – um número inteiro. E qualquer número decimal normalizada pode ser bastante fácil imaginar em forma exponencial. E o número deste tipo têm um tamanho de 4 ou 8 bytes.

Por exemplo, o número decimal 999999 de acordo com a fórmula com uma mantissa normalizado será semelhante 0,999999 10 ~ 3.

Exibindo os dados de texto: um pouco de história

A maioria de todos os usuários de sistemas de computadores ainda usam as informações de teste. E visualizar a informação textual no computador corresponde aos mesmos princípios de código binário.

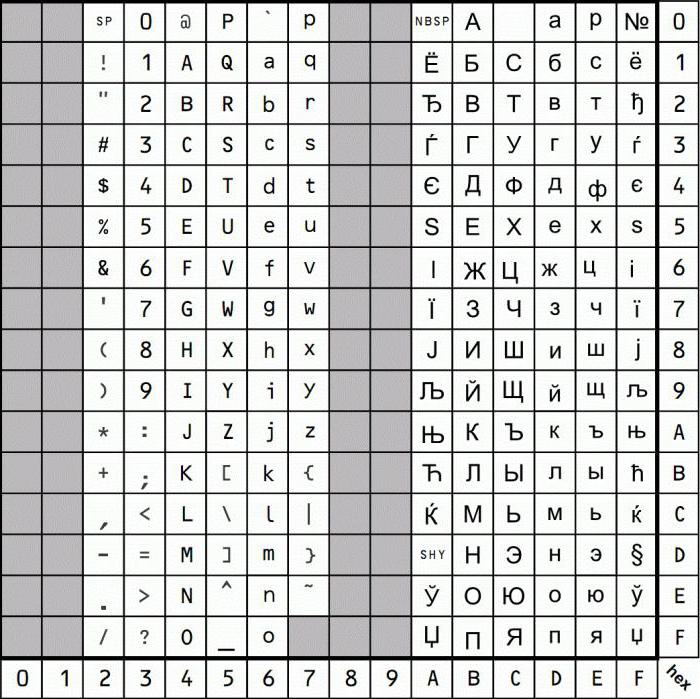

No entanto, devido ao fato de que hoje podemos contar um monte de línguas no mundo, para representar informações de texto usa o sistema de codificações especiais ou tabelas de códigos. Com o advento do MS-DOS foi considerado um padrão básico codificação CP866 e computadores Apple Mac vai usar o seu próprio padrão. Enquanto um especial ISO 8859-5 codificação foi introduzido para o idioma russo. No entanto, com o desenvolvimento da tecnologia informática necessário introduzir novas normas.

variedade de codificações

Por exemplo, no final dos anos 90-s do século passado houve um universal de codificação de Unicode, que pode lidar não apenas dados de texto, mas também áudio e vídeo. Sua peculiaridade é que um único personagem foi alocado mais de um bit, mas dois.

Um pouco mais tarde, existem outras variedades. Para sistemas baseados em Windows, o mais usado é o CP1251 codificação, mas para o idioma russo e ainda é usado por koi-8P – a codificação, que apareceu no final dos anos 70 e 80 foram usados ativamente mesmo em sistemas baseados em UNIX.

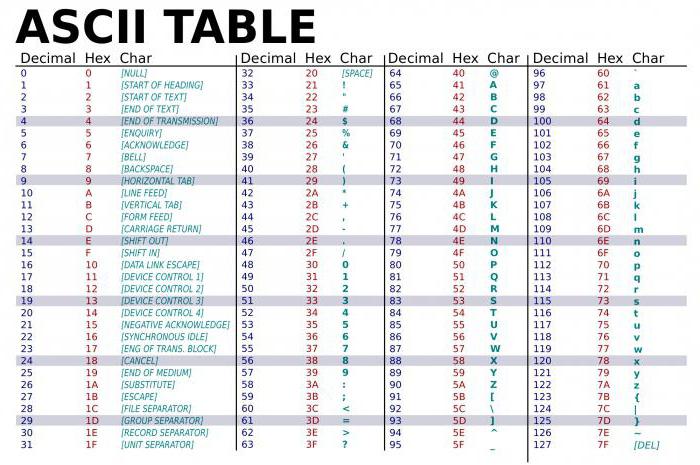

A mesma informação em representação textual de um computador com base na tabela ASCII, incluindo uma base e uma porção estendida. O primeiro inclui códigos de 0 a 127, o segundo – a partir de 128 a 255. No entanto, os primeiros códigos de intervalo 0-32 retiradas para além dos símbolos que são atribuídas às teclas de um teclado padrão e as teclas de função (F1-F12).

Gráficos: Os principais tipos de

Quanto aos gráficos, que é amplamente utilizado no mundo digital de hoje, há algumas nuances. Se você olhar para a representação gráfica de informações em um computador, você deve primeiro pagar a atenção para os principais tipos de imagens. Entre eles estão dois tipos principais – vetoriais e raster.

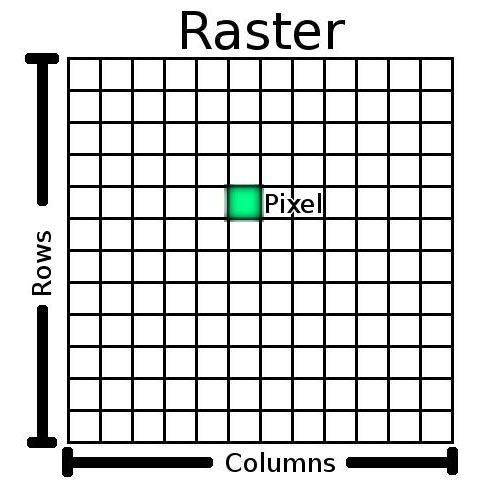

Os gráficos vectoriais baseadas na utilização de formas primitivas (linhas, círculos, curvas, polígonos, e assim por diante. D.), caixas de texto e preenche uma cor específica. Bitmaps são baseados no uso de uma matriz retangular, cada elemento que é chamado de pixel. Além disso, para cada elemento, você pode definir o brilho e cor.

vetorial

Hoje, o uso de vector tem uma área limitada. Eles são bons, por exemplo, ao criar desenhos técnicos e diagramas, ou para bidimensional ou modelos tridimensionais de objetos.

Exemplos vetor formas estacionárias são formatos, como PDF, WMF, PCL. Para mover formas usadas principalmente padrão flash de Macromedia. Mas se falamos sobre a qualidade ou a realização de operações mais complexas do que a mesma escala, é melhor usar formatos raster.

bitmaps

Com objetos raster é muito mais complicado. O fato de que a apresentação de informações na matriz baseado em computador envolve o uso de parâmetros adicionais – profundidade de cor (expressão quantitativa de cores da paleta) em bits, e o tamanho da matriz (número de pixels por polegada, referidos como DPI).

Ou seja, a paleta pode consistir de 16, 256, 65.536 ou 16.777.216 cores, e a matriz pode variar, mas o mais comum é chamado uma resolução de 800×600 pixels (480 000 pixels). De acordo com estes indicadores para determinar o número de bits necessários para armazenar o objeto. Para isso, primeiro use a fórmula N = 2 I, em que N – é o número de cores, e eu – é uma profundidade de cor.

Então calculada a quantidade de informação. Por exemplo, para calcular o tamanho do arquivo da imagem que contém 65.536 cores e uma matriz de 1024×768 pixels. A solução é o seguinte:

- I = log 2 65536, que é de 16 bits;

- o número de pixels 1024 * 768 = 786 432;

- capacidade de memória é de 16 bits de 786 * 432 = 12 582 912 bytes, o que corresponde a 1,2 Mb.

Variedade de áudio: a direção principal da síntese

Apresentação de informações em um computador, chamado de áudio, sujeitos aos mesmos princípios básicos que foram descritas acima. Mas, como para qualquer outra forma de informação objetos para representar o som, também, usaram seus recursos adicionais.

Infelizmente, de alta qualidade de reprodução de som e apareceu em tecnologia informática no último. No entanto, se a reprodução tem se saído mais mal, a síntese de instrumento musical com som real era praticamente impossível. Portanto, algumas gravadoras introduziram seus próprios padrões. Hoje, o mais utilizado, a síntese FM e método de onda mesa.

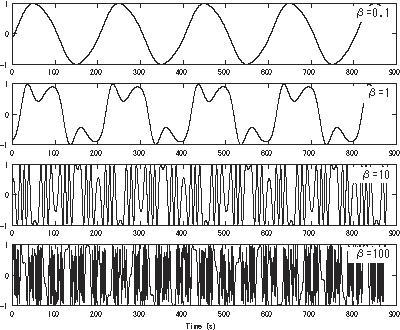

No primeiro caso, isto significa que qualquer som natural, a qual é contínua, pode ser decomposta em uma determinada sequência (sequência de) os harmónicos mais simples, utilizando um método de amostragem e produzir a apresentação da informação na memória de um computador com base no código. Para jogar use o processo inverso, mas neste caso, o inevitável perda de alguns dos componentes que aparecem na qualidade.

Quando a síntese de onda tabela presume-se que existe uma tabela de pré-criada com exemplos do som de instrumentos ao vivo. Tais exemplos são chamados de amostras. Ao mesmo tempo para jogar a equipe MIDI (Musical Instrument Digital Interface) é usado muitas vezes suficiente para perceber a partir do tipo de código de instrumento, altura, duração, intensidade do som e dinâmica de mudança, as configurações de ambiente e outras características. Graças a este tipo de som perto o suficiente perto de natural.

formatos modernos

Enquanto anteriormente a base para WAV padrão foi tomada (na verdade, o próprio som e está na forma de uma onda), ao longo do tempo tornou-se muito inconveniente, se só por causa do fato de que tais arquivos ocupam muito espaço na mídia de armazenamento.

Com o tempo, as tecnologias para comprimir este formato. Por conseguinte, mudaram e formata-se. O mais conhecido hoje pode ser chamado de MP3, OGG, WMA, FLAC e muitos outros.

No entanto, até agora os principais parâmetros de qualquer ficheiro de som permanece frequência de amostragem (44.1 kHz é padrão, embora os valores podem ser encontrados acima e abaixo), e o número de níveis de sinal (16 bits, 32 bits). Em princípio, um tal de digitalização pode ser interpretada como uma representação da informação no computador tipo acústico com base no sinal analógico primário (na natureza de qualquer som é originalmente analógico).

apresentação de vídeo

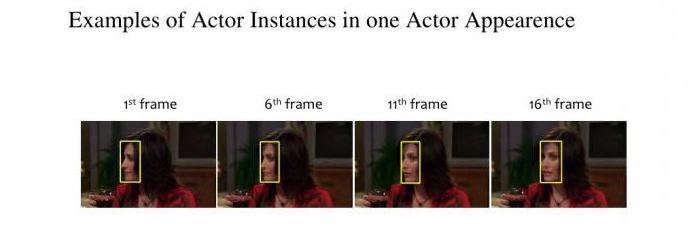

Se os problemas de som foram resolvidos com rapidez suficiente, o vídeo tudo não era tão suave. O problema era que o clipe, um filme ou um jogo de vídeo são uma combinação de vídeo e áudio. Parece que o que poderia ser mais simples do que para combinar movendo objetos de imagem com uma escala? Como se viu, este foi um problema real.

Tudo o que importa é que, do ponto de vista técnico, inicialmente para lembrar o primeiro quadro de cada cena, chamada de chave, e só então a preservar as diferenças (diferença quadros). E o que é mais doloroso, digitalizados ou vídeos criados obtido um tamanho tal que eles armazenar em seu computador ou em mídia removível era simplesmente impossível.

O problema foi resolvido quando apareceu formato AVI que representa um determinado recipiente universal, que consiste de um conjunto de blocos que podem ser armazenados em uma informação arbitrária, assim mesmo comprimido de diferentes maneiras. Assim, até mesmo os arquivos do mesmo formato AVI para o outro pode variar consideravelmente.

E hoje você pode encontrar um monte de outros formatos de vídeo populares, mas para todos eles usaram seu próprio parâmetros e valores de parâmetros, o principal dos quais é o número de quadros por segundo.

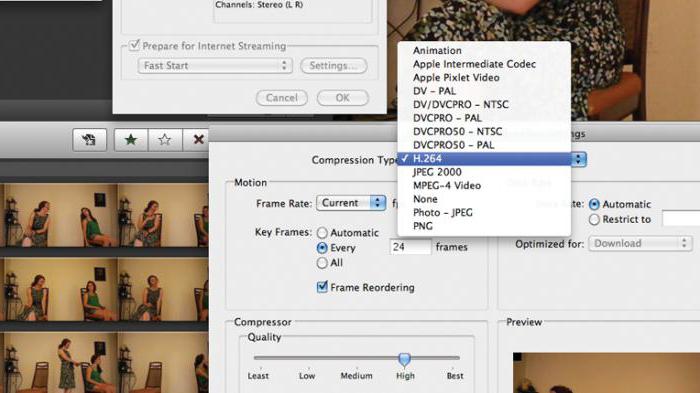

Codecs e decodificadores

Apresentação de informações no computador como o plano é impossível imaginar sem o uso de codecs e decodificadores usados na compressão e descompressão do conteúdo inicial durante a reprodução. Seu próprio nome sugere que alguns codificação (compressa) o sinal, o segundo – pelo contrário – é descompactado.

São eles que são responsáveis pelos conteúdos dos recipientes de qualquer tamanho, bem como determinar o tamanho do arquivo final. Além disso, o importante papel desempenhado pelo parâmetro de resolução, conforme indicado para gráficos raster. Mas hoje podemos até conhecer UltraHD (4k).

conclusão

Se alguma medida resumir o exposto, pode-se notar apenas que os modernos sistemas de computador inicialmente trabalhar exclusivamente na percepção de um código binário (então eles simplesmente não entendem). E seu uso é baseada não apenas fornecer informações, mas também todos conhecidos linguagens de programação hoje. Assim, inicialmente, para entender como tudo funciona, é necessário compreender a essência do uso de seqüências de zeros e uns.